Potenciando la IA en tu bolsillo: Small Language Models con Google AI Edge

En el mundo actual, impulsado por la inteligencia artificial, la posibilidad de ejecutar modelos de machine learning avanzados directamente en dispositivos móviles está revolucionando nuestra relación con la tecnología. Atrás quedaron los días en las que las grandes capacidades de la IA requerían conexión constante con servidores remotos. Con los Small Language Models (SLMs) y la tecnología Google AI Edge, los desarrolladores pueden llevar las últimas capacidades de la inteligencia artificial directamente a dispositivos Android. En este artículo exploramos cómo aprovechar estas tecnologías para crear experiencias de IA rápidas, privadas y eficientes, sin depender de la nube.

¿Qué son los Small Language Models?

Imagina tener una versión miniaturizada de ChatGPT funcionando íntegramente en tu smartphone. Eso es lo que ofrecen los Small Language Models: sistemas de IA de lenguaje compactos, capaces de operar dentro de las limitaciones de los dispositivos móviles, pero lo suficientemente potentes para tareas sofisticadas.

A diferencia de modelos mucho más grandes como GPT-4 o Claude, que contienen cientos de miles de millones de parámetros, los SLMs suelen moverse entre unos pocos millones y hasta 10 mil millones de parámetros. Esta reducción de tamaño los convierte en candidatos ideales para ejecutarse en dispositivos locales.

Pese a su tamaño reducido, estos modelos ofrecen las mismas posibilidades que los Large Language Models:

· Generación de texto

· Resumir información

· Traducción automática

· Preguntas y respuestas

· Razonamiento básico

La clave está en el equilibrio entre capacidad y eficiencia: ofrecen inteligencia útil y son lo suficientemente pequeños para ejecutarse en tu móvil.

¿Por qué ejecutar modelos de lenguaje localmente en Android?

Quizá te preguntes: “¿Por qué ejecutar modelos en el dispositivo si existen APIs en la nube?” Las ventajas son contundentes:

1. Privacidad total

Al procesar los datos completamente en el dispositivo, la información sensible del usuario nunca abandona su móvil. Esto es especialmente relevante para aplicaciones que manejan datos personales, conversaciones privadas o información confidencial, ya que se elimina el riesgo de filtraciones o accesos no autorizados en servidores externos. Además, este enfoque facilita el cumplimiento de regulaciones de protección de datos como el RGPD, ya que el control permanece en manos del usuario.

2. Funcionalidad offline

La ejecución local de modelos permite que las aplicaciones funcionen sin necesidad de conexión a internet. Esto es fundamental para usuarios en zonas con cobertura limitada, durante viajes al extranjero o en situaciones donde la conectividad es inestable o costosa. Además, garantiza que las funcionalidades de IA estén siempre disponibles, proporcionando una experiencia continua y fiable independientemente del entorno de red.

3. Costes reducidos

Al evitar el uso de APIs en la nube para procesar inferencias de IA, se eliminan los costes asociados al tráfico de datos y a las tarifas por uso de servicios cloud. Esto resulta especialmente ventajoso para aplicaciones con un alto volumen de usuarios o interacciones, ya que el procesamiento local escala de forma eficiente sin incrementar los gastos operativos. Además, se reduce la necesidad de infraestructura backend, simplificando la arquitectura y el mantenimiento de la aplicación.

4. Capacidad de cómputo distribuida

Aunque ejecutar modelos de IA localmente puede incrementar el consumo de batería del dispositivo móvil en comparación con delegar el procesamiento a la nube, esta estrategia tiene beneficios a nivel global. Al distribuir la carga de trabajo entre millones de dispositivos, se reduce la dependencia de grandes centros de datos, lo que puede traducirse en menores costes operativos y una reducción significativa del consumo energético centralizado.

“LiteRT aborda cinco limitaciones clave del ODML (On-Device Machine Learning): latencia, privacidad, conectividad, tamaño y consumo energético”, señala la documentación de Google.

Google AI Edge: tu kit para IA en el dispositivo

Google ha construido un ecosistema completo para machine learning en el dispositivo a través de su AI Edge Stack. Dos componentes clave, MediaPipe y LiteRT, son la base para desplegar SLMs (y otros modelos) en Android.

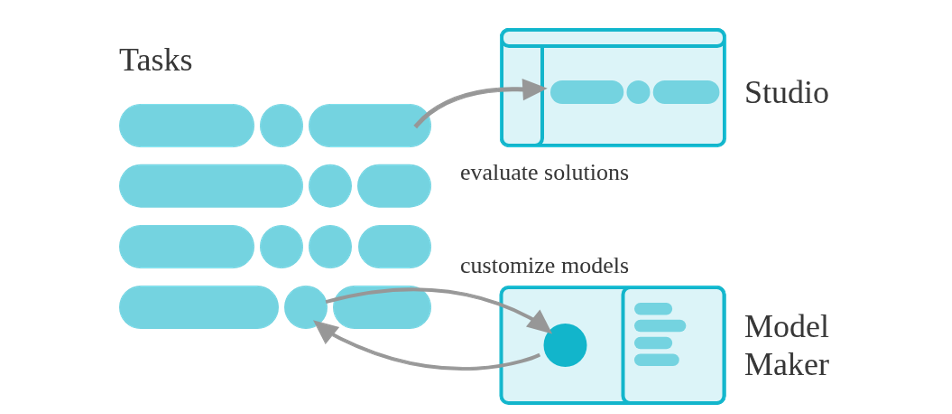

MediaPipe: el framework de soluciones

MediaPipe ofrece soluciones listas para tareas comunes de machine learning, con compatibilidad multiplataforma. Incluye:

· MediaPipe Tasks: APIs para desplegar soluciones, incluyendo la ejecución de LLMs.

· MediaPipe Models: Modelos preentrenados y listos para usar en diversas tareas.

· MediaPipe Studio: Herramientas para visualizar, evaluar y comparar soluciones.

· MediaPipe Model Maker: Personalización de modelos con tus propios datos.

¿Qué son los Small Language Models?

Imagina tener una versión miniaturizada de ChatGPT funcionando íntegramente en tu smartphone. Eso es lo que ofrecen los Small Language Models: sistemas de IA de lenguaje compactos, capaces de operar dentro de las limitaciones de los dispositivos móviles, pero lo suficientemente potentes para tareas sofisticadas.

A diferencia de modelos mucho más grandes como GPT-4 o Claude, que contienen cientos de miles de millones de parámetros, los SLMs suelen moverse entre unos pocos millones y hasta 10 mil millones de parámetros. Esta reducción de tamaño los convierte en candidatos ideales para ejecutarse en dispositivos locales.

Pese a su tamaño reducido, estos modelos ofrecen las mismas posibilidades que los Large Language Models:

· Generación de texto

· Resumir información

· Traducción automática

· Preguntas y respuestas

· Razonamiento básico

La clave está en el equilibrio entre capacidad y eficiencia: ofrecen inteligencia útil y son lo suficientemente pequeños para ejecutarse en tu móvil.

¿Por qué ejecutar modelos de lenguaje localmente en Android?

Quizá te preguntes: “¿Por qué ejecutar modelos en el dispositivo si existen APIs en la nube?” Las ventajas son contundentes:

1. Privacidad total

Al procesar los datos completamente en el dispositivo, la información sensible del usuario nunca abandona su móvil. Esto es especialmente relevante para aplicaciones que manejan datos personales, conversaciones privadas o información confidencial, ya que se elimina el riesgo de filtraciones o accesos no autorizados en servidores externos. Además, este enfoque facilita el cumplimiento de regulaciones de protección de datos como el RGPD, ya que el control permanece en manos del usuario.

2. Funcionalidad offline

La ejecución local de modelos permite que las aplicaciones funcionen sin necesidad de conexión a internet. Esto es fundamental para usuarios en zonas con cobertura limitada, durante viajes al extranjero o en situaciones donde la conectividad es inestable o costosa. Además, garantiza que las funcionalidades de IA estén siempre disponibles, proporcionando una experiencia continua y fiable independientemente del entorno de red.

3. Costes reducidos

Al evitar el uso de APIs en la nube para procesar inferencias de IA, se eliminan los costes asociados al tráfico de datos y a las tarifas por uso de servicios cloud. Esto resulta especialmente ventajoso para aplicaciones con un alto volumen de usuarios o interacciones, ya que el procesamiento local escala de forma eficiente sin incrementar los gastos operativos. Además, se reduce la necesidad de infraestructura backend, simplificando la arquitectura y el mantenimiento de la aplicación.

4. Capacidad de cómputo distribuida

Aunque ejecutar modelos de IA localmente puede incrementar el consumo de batería del dispositivo móvil en comparación con delegar el procesamiento a la nube, esta estrategia tiene beneficios a nivel global. Al distribuir la carga de trabajo entre millones de dispositivos, se reduce la dependencia de grandes centros de datos, lo que puede traducirse en menores costes operativos y una reducción significativa del consumo energético centralizado.

“LiteRT aborda cinco limitaciones clave del ODML (On-Device Machine Learning): latencia, privacidad, conectividad, tamaño y consumo energético”, señala la documentación de Google.

Google AI Edge: tu kit para IA en el dispositivo

Google ha construido un ecosistema completo para machine learning en el dispositivo a través de su AI Edge Stack. Dos componentes clave, MediaPipe y LiteRT, son la base para desplegar SLMs (y otros modelos) en Android.

MediaPipe: el framework de soluciones

MediaPipe ofrece soluciones listas para tareas comunes de machine learning, con compatibilidad multiplataforma. Incluye:

· MediaPipe Tasks: APIs para desplegar soluciones, incluyendo la ejecución de LLMs.

· MediaPipe Models: Modelos preentrenados y listos para usar en diversas tareas.

· MediaPipe Studio: Herramientas para visualizar, evaluar y comparar soluciones.

· MediaPipe Model Maker: Personalización de modelos con tus propios datos.

Gráfico 1

LiteRT: el motor de ejecución

LiteRT (antes TensorFlow Lite) es el runtime de alto rendimiento de Google para IA en dispositivos. Proporciona:

· Soporte multiplataforma: Compatible con Android, iOS, Linux embebido y microcontroladores.

· Conversión de modelos: Desde TensorFlow, PyTorch y JAX.

· Aceleración hardware: Optimización mediante GPU y NPU.

· Soporte para varios lenguajes: SDKs para Java/Kotlin, Swift, Objective-C, C++ y Python.

Adaptando modelos a tu caso de uso

Tal y como hemos comentado, los SLM ofrecen muchas posibilidades, aunque no son los modelos más potentes. En algunas ocasiones será interesante ajustar estos modelos a nuestros casos de uso específicos para que su funcionamiento sea mejor. Una de las maneras más habituales de llevar a cabo este proceso es hacer uso de la técnica de fine-tuning LoRA.

Fine-tuning con LoRA (Low-Rank Adaptation)

Low-Rank Adaptation (LoRA) es una técnica innovadora que permite adaptar modelos de inteligencia artificial, como Gemma 3, a tareas específicas sin reentrenar todos sus parámetros. En lugar de modificar los miles de millones de parámetros del modelo original, LoRA introduce dos matrices pequeñas y entrenables (A y B) que aproximan los cambios necesarios mediante low rank decomposition. Este enfoque reduce drásticamente los recursos computacionales: por ejemplo, en GPT-3, disminuye los parámetros entrenables en 10,000 veces y la memoria GPU requerida en un 66%. Además, al mantener congelados los pesos originales, preserva el conocimiento general del modelo mientras se especializa en nuevas tareas, evitando lo que se conoce como el "Catastrophic forgetting".

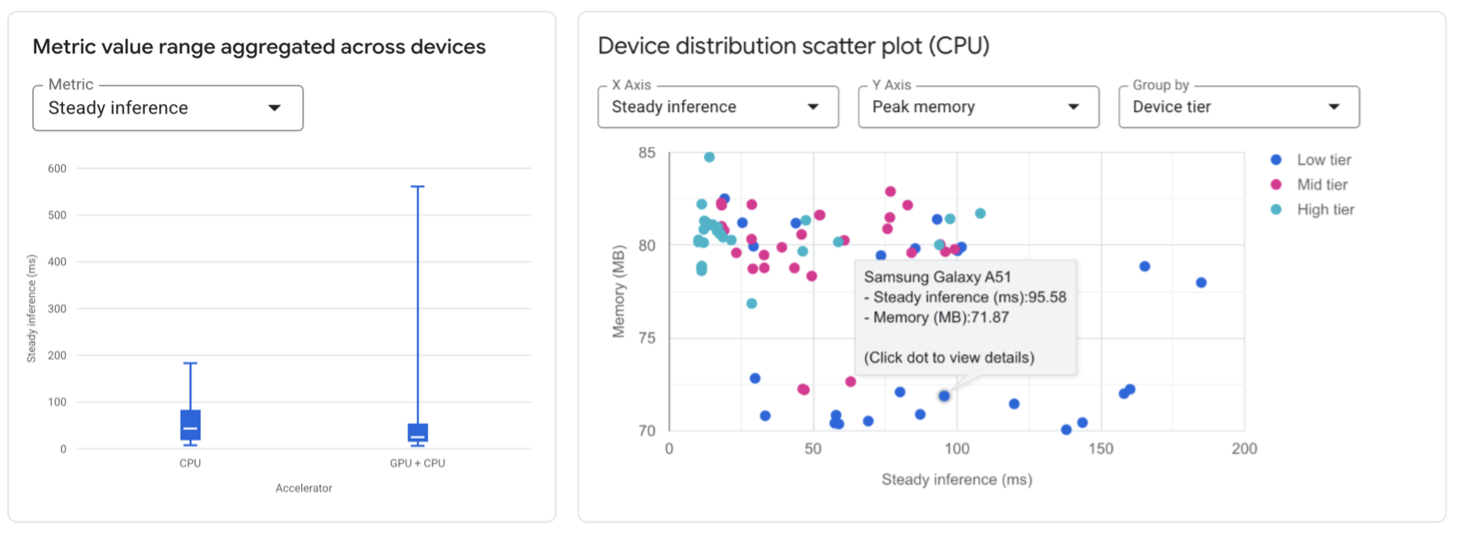

Prueba de rendimiento con AI Edge Portal

Tras personalizar tu modelo, es clave verificar su rendimiento en diferentes dispositivos Android. La nueva AI Edge Portal lo facilita. Todavía está en una fase de beta privada a la que te puedes apuntar. En un futuro permitirá:

· Probar modelos en cientos de dispositivos reales.

· Detectar variaciones de rendimiento según hardware.

· Comparar configuraciones de modelos.

· Acceder a métricas detalladas de latencia y uso de memoria.

LiteRT (antes TensorFlow Lite) es el runtime de alto rendimiento de Google para IA en dispositivos. Proporciona:

· Soporte multiplataforma: Compatible con Android, iOS, Linux embebido y microcontroladores.

· Conversión de modelos: Desde TensorFlow, PyTorch y JAX.

· Aceleración hardware: Optimización mediante GPU y NPU.

· Soporte para varios lenguajes: SDKs para Java/Kotlin, Swift, Objective-C, C++ y Python.

Adaptando modelos a tu caso de uso

Tal y como hemos comentado, los SLM ofrecen muchas posibilidades, aunque no son los modelos más potentes. En algunas ocasiones será interesante ajustar estos modelos a nuestros casos de uso específicos para que su funcionamiento sea mejor. Una de las maneras más habituales de llevar a cabo este proceso es hacer uso de la técnica de fine-tuning LoRA.

Fine-tuning con LoRA (Low-Rank Adaptation)

Low-Rank Adaptation (LoRA) es una técnica innovadora que permite adaptar modelos de inteligencia artificial, como Gemma 3, a tareas específicas sin reentrenar todos sus parámetros. En lugar de modificar los miles de millones de parámetros del modelo original, LoRA introduce dos matrices pequeñas y entrenables (A y B) que aproximan los cambios necesarios mediante low rank decomposition. Este enfoque reduce drásticamente los recursos computacionales: por ejemplo, en GPT-3, disminuye los parámetros entrenables en 10,000 veces y la memoria GPU requerida en un 66%. Además, al mantener congelados los pesos originales, preserva el conocimiento general del modelo mientras se especializa en nuevas tareas, evitando lo que se conoce como el "Catastrophic forgetting".

Prueba de rendimiento con AI Edge Portal

Tras personalizar tu modelo, es clave verificar su rendimiento en diferentes dispositivos Android. La nueva AI Edge Portal lo facilita. Todavía está en una fase de beta privada a la que te puedes apuntar. En un futuro permitirá:

· Probar modelos en cientos de dispositivos reales.

· Detectar variaciones de rendimiento según hardware.

· Comparar configuraciones de modelos.

· Acceder a métricas detalladas de latencia y uso de memoria.

Gráfico 2

Optimización del rendimiento

Para asegurar un funcionamiento fluido de los SLMs en Android, sigue estas buenas prácticas:

1. Cuantiza tus modelos: para reducir tamaño y acelerar la inferencia.

2. Aprovecha la aceleración hardware: usa GPU o NPU cuando estén disponibles.

3. Limita la longitud de secuencia: ajusta la generación según la capacidad del dispositivo.

4. Lazy loading: carga los modelos solo cuando sea necesario.

5. Equilibra tamaño y rendimiento: no todas las aplicaciones necesitan el modelo más grande.

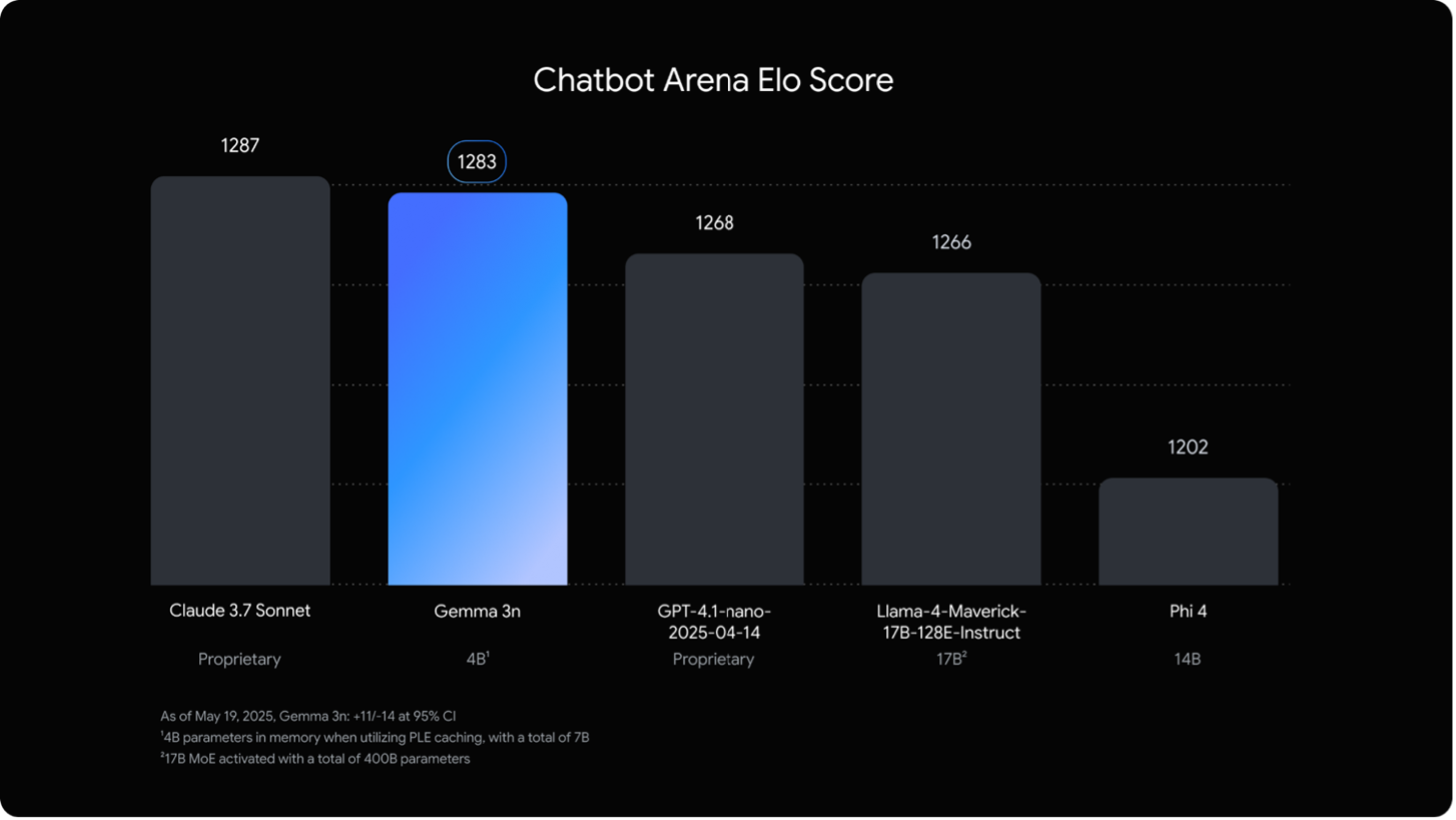

El futuro de la IA en el dispositivo

El panorama de los modelos de lenguaje en el dispositivo evoluciona rápidamente. Novedades como el rendimiento y las capacidades multimodales del nuevo modelo de Google Gemma 3n no hacen más que inyectar expectación alrededor de este mundo.

Para asegurar un funcionamiento fluido de los SLMs en Android, sigue estas buenas prácticas:

1. Cuantiza tus modelos: para reducir tamaño y acelerar la inferencia.

2. Aprovecha la aceleración hardware: usa GPU o NPU cuando estén disponibles.

3. Limita la longitud de secuencia: ajusta la generación según la capacidad del dispositivo.

4. Lazy loading: carga los modelos solo cuando sea necesario.

5. Equilibra tamaño y rendimiento: no todas las aplicaciones necesitan el modelo más grande.

El futuro de la IA en el dispositivo

El panorama de los modelos de lenguaje en el dispositivo evoluciona rápidamente. Novedades como el rendimiento y las capacidades multimodales del nuevo modelo de Google Gemma 3n no hacen más que inyectar expectación alrededor de este mundo.

Gráfico 3

Nuevas librerías de RAG y Function Calling para los SLM que se irán ampliando apuntan a aplicaciones cada vez más sofisticadas.

Veremos avances en:

· Eficiencia y rendimiento de modelos.

· Capacidades multimodales.

· Aceleración hardware para IA.

· Herramientas para personalización.

Conclusión

Los Small Language Models impulsados por Google AI Edge representan un gran avance para llevar la IA directamente a dispositivos Android. Al eliminar la necesidad de conectividad con la nube, estas tecnologías permiten aplicaciones más rápidas, privadas y eficientes.

Ya sea que estés creando una herramienta de generación de contenido, un asistente inteligente o una app de traducción, la combinación de MediaPipe y LiteRT es una base robusta para implementar SLMs que funcionan íntegramente en el dispositivo.

El futuro de la IA no está solo en la nube: está en tu bolsillo, funcionando localmente en tu dispositivo Android.

¿Listo para experimentar? Visita la comunidad LiteRT en Hugging Face para explorar los modelos disponibles y visita el repositorio google-ai-edge/gallery para ver una implementación en Android de todos estos conceptos.

Referencias y enlaces de interés

1. https://www.ibm.com/think/topics/small-language-models

2. https://huggingface.co/blog/jjokah/small-language-model

3. https://ai.google.dev/edge/litert

4. https://ai.google.dev/edge/mediapipe

5. https://ai.google.dev/gemma/docs/core/lora_tuning

6. https://github.com/google-ai-edge/gallery

Veremos avances en:

· Eficiencia y rendimiento de modelos.

· Capacidades multimodales.

· Aceleración hardware para IA.

· Herramientas para personalización.

Conclusión

Los Small Language Models impulsados por Google AI Edge representan un gran avance para llevar la IA directamente a dispositivos Android. Al eliminar la necesidad de conectividad con la nube, estas tecnologías permiten aplicaciones más rápidas, privadas y eficientes.

Ya sea que estés creando una herramienta de generación de contenido, un asistente inteligente o una app de traducción, la combinación de MediaPipe y LiteRT es una base robusta para implementar SLMs que funcionan íntegramente en el dispositivo.

El futuro de la IA no está solo en la nube: está en tu bolsillo, funcionando localmente en tu dispositivo Android.

¿Listo para experimentar? Visita la comunidad LiteRT en Hugging Face para explorar los modelos disponibles y visita el repositorio google-ai-edge/gallery para ver una implementación en Android de todos estos conceptos.

Referencias y enlaces de interés

1. https://www.ibm.com/think/topics/small-language-models

2. https://huggingface.co/blog/jjokah/small-language-model

3. https://ai.google.dev/edge/litert

4. https://ai.google.dev/edge/mediapipe

5. https://ai.google.dev/gemma/docs/core/lora_tuning

6. https://github.com/google-ai-edge/gallery